Cuando el Kinect de Microsoft – un dispositivo que le permite a los usuarios de Xbox controlar juegos con señas físicas – llegó al mercado, los científicos de computadoras inmediatamente comenzaron a hackearlo. El Kinect, una barra negra de plástico de alrededor de 28 centímetros de ancho y con un buscador infrarrojo de rango y una cámara dentro, produce un mapa visual de la escena ante él, con información sobre la distancia hacia objetos individuales. Tan solo en el MIT (Massachusetts Institute of Technology) los investigadores han utilizado el Kinect para crear una interfaz de computadora al estilo de “Minority Report”, un sistema de navegación para helicópteros robóticos miniatura y un transmisor de video holográfico, entre otras cosas.

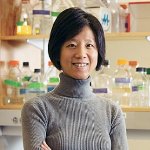

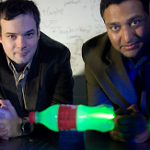

Ahora imagina un dispositivo que provee información de profundidad más precisa que el Kinect, tiene un rango mayor y trabaja bajo todas las condiciones de iluminación – pero es tan pequeño, barato y eficiente en su consumo de energía que podría ser incorporado en un teléfono celular por un pequeño costo extra. Ésta es la promesa del trabajo reciente de Vivek Goyal, profesor de Ingeniería Eléctrica, y su grupo en el laboratorio de electrónica del MIT.

“La adquisición de información tridimensional se ha convertido en un tema realmente popular,” dijo Goyal. “En la electrónica para consumidores, la gente está muy interesada en la tercera dimensión para la comunicación inmersiva, pero también están interesados en la tercera dimensión para la interacción humana con computadoras.”

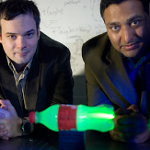

Andrea Colaco, un estudiante graduado del Laboratorio de Medios del MIT y uno de los co-autores en una revista académica que será presentada en la Conferencia Internacional de Acústica, Habla y Procesamiento de Señales del IEEE (Instituto de Ingenieros Eléctricos y Electrónicos) en Marzo, apunta que las interfaces gestuales hacen mucho más fácil que personas múltiples interactúen con una computadora a la vez – como en los juegos de baile que el Kinect ha popularizado.

“Cuando estás hablando de una sola persona y una máquina, ya hemos optimizado la forma en la que lo hacemos,” dice Colaco. “Pero cuando es un grupo, hay menos flexibilidad.”

Ahmed Kirmani, un estudiante graduado en el Departamento de Ingeniería Eléctrica y Ciencia Computacional y otro autor de la revista académica agrega: “Las pantallas tridimensionales están muy avanzadas en términos de tecnología comparadas con las cámaras tridimensionales. Tienes disponibles estas pantallas tridimensionales de alta resolución que tienen tasas de cuadros por segundo en tiempo real.”

“Sentir es siempre difícil,” añade, “y mostrar es fácil.”

Adentrándonos

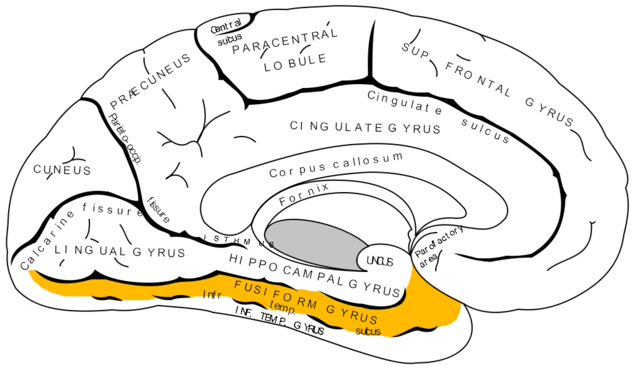

Al igual que otros sofisticados dispositivos que sienten profundidad, el sistema de los investigadores del MIT utilizan el “tiempo de vuelo” de partículas de luz para medir la profundidad: Un pulso de luz láser infrarrojo es disparado hacia la escena, y la cámara mide el tiempo que le toma a la luz regresar de los objetos a diferentes distancias.

Los sistemas tradicionales de tiempo de vuelo usan uno de dos acercamientos para construir un “mapa de profundidad” de una escena. LIDAR (Light Detection and Ranging – Detección de Luz y Rango) usa un haz láser de escaneo que dispara una serie de pulsos, cada uno corresponde a un punto en una malla, y separadamente mide su tiempo de vuelta. Pero esto hace la adquisición de datos más lenta, y requiere un sistema mecánico para redirigir continuamente el láser. La alternativa, empleada por las llamadas cámaras de tiempo de vuelo, es iluminar toda la escena con pulsos de láser y utilizar un banco de sensores para registrar la luz que regresa. Pero los sensores capaces de distinguir pequeños grupos de partículas de luz – fotones – son caros: Una cámara típica de tiempo de vuelo cuesta miles de dólares.

En contraste, el sistema de los investigadores del MIT utiliza un solo detector de luz – una cámara de un píxel. Pero utilizando trucos matemáticos inteligentes, puede lograr crear el mapa de profundidad de la escena disparando el láser un número limitado de veces.

El primer truco es uno común en el campo de la sensibilidad comprimida: La luz emitida por el láser pasa a través de una serie de patrones de luz y cuadros oscuros generados aleatoriamente, como un tablero de damas irregular. Impresionantemente, esto provee suficiente información para que los algoritmos puedan reconstruir una imagen bi-dimensional visual de las intensidades de la luz medidas por un solo píxel.

En experimentos, los investigadores encontraron que el número de destellos de láser – y el número de patrones del tablero de damas – que necesitaban para construir un mapa de profundidad adecuado era alrededor de 5% el número de píxeles en la imagen final. Un sistema LIDAR, en contraste, necesitaría enviar un pulso de láser por cada píxel.

Para agregar la tercera dimensión crucial al mapa de profundidad, los investigadores usan otra técnica, llamada procesamiento de señal paramétrica. Esencialmente, asumen que todas las superficies de la escena, como sea que estén orientadas con respecto a la cámara, son paneles planos. Aunque esto no es estrictamente verdadero, las matemáticas de la luz que rebota de superficies planas es mucho más sencilla que la de la luz que rebota en superficies curvas. El algoritmo paramétrico de los investigadores encaja la información sobre la luz que regresa al modelo de panel plano que mejor se le ajusta, creando un muy preciso mapa de profundidad con un mínimo de información visual.

Lo barato

De hecho, el algoritmo le permite a los investigadores salirse con la suya aún con hardware relativamente crudo. Su sistema mide el tiempo de vuelo de fotones utilizando un fotodetector barato y un convertidor de análogo a digital ordinario – un componente ya encontrado en todos los teléfonos celulares. Al sensor le toma alrededor de 0.7 nanosegundos registrar un cambio a su entrada.

Eso es tiempo suficiente para que la luz viaje 21 centímetros, dice Goyal. “Entonces para un intervalo de profundidad de 10 y medio centímetros – estoy dividiendo entre dos por que la luz tiene que ir y volver – toda la información se está juntando,” dice. Sin embargo, debido al algoritmo paramétrico, el sistema de los investigadores puede distinguir objetos que solo tienen una diferencia de profundidad de 2 milímetros. “No parecería que se puede obtener toda esta información fuera de esta señal cuando se pone junta,” dice Goyal.

El algoritmo de los desarrolladores es muy sencillo de ejecutar en el tipo de procesadores encontrados ordinariamente en un teléfono inteligente (smartphone). En contraste, para interpretar los datos provistos por el Kinect, el Xbox requiere del poder extra de una unidad de procesamiento gráfico, una poderosa pieza de hardware de propósito específico.

“Ésta es una manera de adquirir información de profundidad completamente nueva,” dice Yue M. Lu, un profesor asistente de ingeniería eléctrica de la Universidad de Harvard. “Es una manera muy inteligente de obtener esta información.” Un obstáculo para el uso del sistema en un dispositivo de mano, especula Lu, podría ser la dificultad de emitir pulsos de luz de la intensidad adecuada sin terminarse la batería.

Pero la intensidad de la luz requerida para obtener lecturas precisas de profundidad es proporcional a la distancia de los objetos en la escena, explica Goyal, y las aplicaciones que sería más probable que resultaran útiles en un dispositivo portátil – como interfaces de gestos – lidian con objetos cercanos. Además, explica, el sistema de los investigadores hace un estimado inicial de la distancia de los objetos y ajusta la intensidad de los pulsos de luz subsecuentes según sea necesario.

En cualquier caso, el gigante de las telecomunicaciones Qualcomm ve la suficiente promesa en la tecnología que ha seleccionado a un equipo formado por Kirmani y Colaco como uno de los ocho ganadores – de 146 que aplicaron a un grupo de universidades selectas – para apoyarlos con USD$100,000 a través de su programa de innovación del 2011.

Fuente:

http://web.mit.edu/ (en inglés)