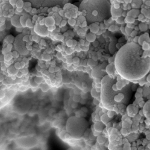

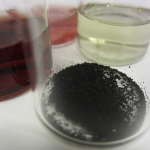

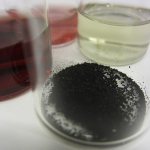

Pequeños filmes de antimonio-bismuto tienen el potencial para nuevos chips semiconductores y dispositivos termoeléctricos.

David L. Chandler, MIT News Office. Original (en inglés)

El grafeno, una capa de carbono de un solo átomo de grueso, ha dado lugar a muchas investigaciones sobre sus propiedades únicas electrónicas, ópticas y mecánicas. Ahora, investigadores en el MIT (Massachusetts Institute of Technology – Instituto Tecnológico de Massachusetts) han encontrado otro compuesto que comparte muchas de las características inusuales del grafeno – y en algunos casos tiene interesantes propiedades complementarias a este material tan discutido.

El material, un delgado filme de bismuto-antimonio, puede tener una variedad de diferentes características controlables, encontraron los investigadores, dependiendo de la temperatura ambiente y la presión, el grueso del material y la orientación de su crecimiento. La investigación, llevada a cabo por el candidato a doctorado de ciencia e ingeniería de materiales Shuang Tang y el profesor del instituto Mildred Dresselhaus, aparece en el diario Nano Letters.

Cómo el grafeno, el nuevo material tiene propiedades electrónicas que son conocidas como conos Dirac bidimensionales, un término que se refiere al trazado gráfico de energía con forma de cono contra la cantidad de movimiento para electrones moviéndose a través del material. Estas propiedades inusuales – que permiten a los electrones moverse de una manera diferente a la que es posible en la mayoría de los materiales – podría dar a los filmes de bismuto-antimonio propiedades que son altamente deseables para aplicaciones en la manufactura de chips electrónicos de próxima generación o en generadores y enfriadores termoeléctricos.

En dichos materiales, dice Tang, los electrones “pueden viajar como un rayo de luz”, potencialmente haciendo posibles nuevos chips con habilidades computacionales mucho más rápidas. El flujo de electrones podría ser en algunos casos cientos de veces más rápido que en chips convencionales de silicio, dice.

Similarmente, en una aplicación termoeléctrica – donde una diferencia de temperatura entre los dos lados de un dispositivo crea un flujo de corriente eléctrica – el movimiento mucho más rápido de electrones, junto con propiedades fuertes de aislamiento térmico, podrían permitir producción de energía mucho más eficiente. Esto podría probar ser útil en darle energía a satélites al explotar la diferencia de temperatura entre la luz solar y los lados oscuros, dice Tang.

Dichas aplicaciones siguen especulativas en este punto, dice Dresselhaus, por que se necesita más investigación para analizar propiedades adicionales y eventualmente para probar muestras del material. Este análisis inicial estuvo basado principalmente en modelado teórico de las propiedades del filme de bismuto-antimonio.

Hasta que este análisis sea llevado a cabo, dice Dresselhaus, “nunca pensamos en el bismuto” como teniendo el potencial para propiedades de cono de Dirac. Pero encuentros recientes inesperados involucrando una clase de materiales llamados aislantes topológicos sugirió otra cosa: Experimentos llevados a cabo por un colaborador Ucraniano sugirió que las propiedades del cono de Dirac podrían ser posibles en filmes de bismuto-antimonio.

Mientras que resulta que los delgados filmes de bismuto-antimonio pueden tener algunas propiedades similares a aquellas del grafeno, cambiando las condiciones también permite que una variedad de otras propiedades sean realizadas. Eso abre la posibilidad de diseñar dispositivos electrónicos hecho del mismo material con propiedades variantes, depositando una capa sobre la otra, en lugar de capas de diferentes materiales.

Las propiedades inusuales del material pueden variar de una dirección a otra: Electrones moviéndose en una dirección podrían seguir las leyes de la mecánica clásica, por ejemplo, mientras que aquellos moviéndose en una dirección perpendicular obedecen la física relativista. Esto podría permitir dispositivos que prueben la física relativista en una manera más barata y más simple que los sistemas existentes, dice Tang, aunque esto falta por probarse a través de experimentos.

“Nadie ha hecho ningún dispositivo todavía” del nuevo material, advierte Dresselhaus, pero añade que los principios son cercanos y los análisis necesarios deberían de tomar menos de un año en llevarse a cabo.

“Todo puede suceder, realmente no sabemos”, dice Dresselhaus. Dichos detalles quedan por ser subsanados, ella dice, añadiendo: “Muchos misterios quedan antes de que tengamos un dispositivo real”.

Joseph Heremans, un profesor de física en la Universidad Estatal de Ohio quien no estuvo involucrado en esta investigación, dice que mientras que algunas propiedades inusuales del bismuto se han conocido por un largo tiempo, “lo que es sorprendente es la riqueza de los sistemas calculados por Tang y Dresselhaus. La belleza de esta predicción es mejorada aún más por el hecho de que el sistema es bastante accesible experimentalmente”.

Heremans agrega que en investigaciones posteriores sobre las propiedades del material de bismuto-antimonio, “habrá dificultades, y algunas pocas ya son conocidas”, pero dice que las propiedades son lo suficientemente interesantes y prometedoras que “este artículo debe estimular un esfuerzo experimental más grande”.

El trabajo fue patrocinado con una beca de la Oficina de Investigación Científica de la Fuerza Aérea de los Estados Unidos.

Imagen: Shuang Tang / Profesora Mildred Dresselhaus.

Reimpreso con permiso de MIT News.

Fuente

http://web.mit.edu/ (en inglés)