Simplemente activando un pequeño número de neuronas puede evocar una memoria entera.

Cathryn Delude, Picower Institute for Learning and Memory. Original (En inglés).

Nuestras memorias apreciadas o temidas – ese primer beso o un golpe en la noche – dejan rastros de memorias que podemos evocar de tiempos pasados, completos con tiempo, lugar y todas las sensaciones de la experiencia. Neurocientíficos llaman a estos rastros engramas de memoria.

Pero, ¿son los engramas conceptuales, o son una red física de neuronas en el cerebro? En un nuevo estudio del MIT (Massachusetts Institute of Technology – Instituto Tecnológico de Massachusetts), los investigadores usaron optogenética para mostrar que las memorias realmente residen en células del cerebro muy específicas, y que simplemente activando una pequeña fracción de células del cerebro pueden recordar una memoria entera – explicando, por ejemplo, como Marcel Proust puede recapitular su niñez a partir del aroma de una galleta.

“Demostramos que el comportamiento basado en la cognición de alto nivel, como la expresión de una memoria específica, puede ser generada en un mamífero por una activación física altamente específica de una pequeña subpoblación de células cerebrales, en este caso por luz”, dice Susumu Tonegawa, el Profesor de Biología y Neurociencia en el MIT y autor líder del estudio reportado en línea en el diario Nature. “Esta es la prueba del siglo 21 rigurosamente diseñada que el neurocirujano canadiense Wilder Penfield ideó a principios del siglo pasado mediante una observación accidental que sugirió que la mente esta basada en materia”.

En aquella famosa cirugía, Penfield trató a pacientes de epilepsia al sacar partes del cerebro donde se originaban los ataques. Para asegurarse de que destruyó solamente las neuronas problemáticas, Penfield estimuló el cerebro con pequeñas descargas de electricidad mientras que los pacientes, que estaban bajo anestesia local, reportaban lo que experimentaban. Notablemente, algunos recordaron vívidamente eventos complejos enteros cuando Penfield estimuló solo unas pocas neuronas en el hipocampo, una región que ahora se considera esencial para la formación y el recordar memorias episódicas.

Los científicos han continuado explorando el fenómeno pero, hasta ahora, nunca se había probado que la reactivación directa del hipocampo era suficiente para causar el recordar memorias.

Arrojando luz en el asunto

Adelantándonos a la introducción, hace siete años, de la optogenética, que puede estimular neuronas que son genéticamente modificadas para expresar proteínas activadas por luz. “Pensamos que podríamos utilizar esta nueva tecnología para probar directamente la hipótesis sobre el cifrado de memorias y el almacenamiento en un experimento de mímica”, dice el coautor Xu Liu, un postdoctorado en el laboratorio de Tonegawa.

“Queríamos activar artificialmente una memoria sin la experiencia sensorial requerida, que provee evidencia experimental de que aún fenómenos efímeros, como memorias personales, residen en la maquinaria física del cerebro”, agrega el coautor Steve Ramirez, un estudiante graduado en el laboratorio de Tonegawa.

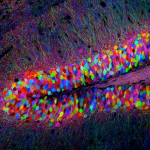

Los investigadores identificaron primero un grupo específico de células cerebrales en el hipocampo que solo estaban activas cuando un ratón estaba aprendiendo sobre un nuevo entorno. Determinaron qué genes fueron activados en esas células, y los mezclaron con un gen para channelrhodopsin-2 (ChR2), una proteína activada por luz usada en la optogenética.

Después, estudiaron a ratones con esta copla genética en las células de la circunvolución dentada del hipocampo, usando pequeñas fibras ópticas para entregar pulsos de luz a las neuronas. La proteína activada por luz solo se expresaría en las neuronas involucradas con el aprendizaje de experiencias – una manera ingeniosa de permitir el etiquetado de la red física de neuronas asociadas con un engrama de memoria específico para una experiencia específica.

Finalmente, el ratón entró en un entorno y, después de unos pocos minutos de exploración, recibió un pequeña descarga, aprendiendo a temer el entorno en particular donde ocurrió la descarga. Las células cerebrales activadas durante este condicionamiento de miedo se volvieron etiquetadas con ChR2. Más tarde, cuando fue expuesto a pulsos de luz desencadenantes en un entorno completamente diferente, las neuronas involucradas en la memoria de miedo se activaron – y el ratón rápidamente entró en un agazapo defensivo e inmóvil.

Memoria falsa

Este congelamiento inducido por luz sugirió que los animales estaban recordando la memoria de recibir una descarga eléctrica. El ratón aparentemente percibió este recuerdo de una memoria de miedo – pero la memoria fue reactivada artificialmente. “Nuestros resultados muestran que las memorias realmente residen en células cerebrales muy específicas”, dijo Liu, “y simplemente al reactivar esas células por medios físicos, como la luz, una memoria entera puede ser recordada”.

Refiriéndose al filósofo francés del siglo 17 que escribió, “pienso, por lo tanto existo,” Tonegawa dice, “René Descartes no creía que la mente pudiera ser estudiada como una ciencia natural. Estaba equivocado. Este método experimental es la manera de demostrar que la mente, como los recuerdos de memorias, están basados en cambios en la materia”.

“Este trabajo notable exhibe el poder de combinar las últimas tecnología para atacar uno de los problemas centrales de la neurobiología”, dice Charles Stevens, un profesor en el Laboratorio de Neurobiología Molecular en el Instituto Salk quien no estuvo involucrado en esta investigación. “Mostrando que la reactivación de esas células nerviosas que estuvieron activas durante el aprendizaje pueden reproducir el comportamiento aprendido es realmente un logro”.

El método también podría tener aplicaciones en el estudio de las enfermedades neurodegenerativas y neuropsiquiátricas. “Mientras más sepamos sobre las piezas móviles que forman nuestros cerebros”, dice Ramirez, “estaremos mejor equipados para encontrar lo que sucede cuando las piezas del cerebro se rompen”.

Otros contribuyentes a este estudio fueron Karl Deissenroth de la Universidad de Stanford, cuyo laboratorio desarrollo la optogenética, y Petti T. Pang, Corey B. Puryear y Arvind Govindarajan del Centro RIKEN-MIT para Genética de Circuitos Neurales en el Instituto Picower para el Aprendizaje y la Memoria en el MIT. El trabajo fue apoyado por los Institutos Nacionales de Salud y el Instituto RIKEN de Ciencia del Cerebro.

Reimpreso con permiso de MIT News.

Fuente

http://web.mit.edu/ (en inglés)